Google PlayにおけるA/Bテストの信頼性向上

本記事は、2020年5月13日に開催されたASO Conference Onlineでも発表されました。

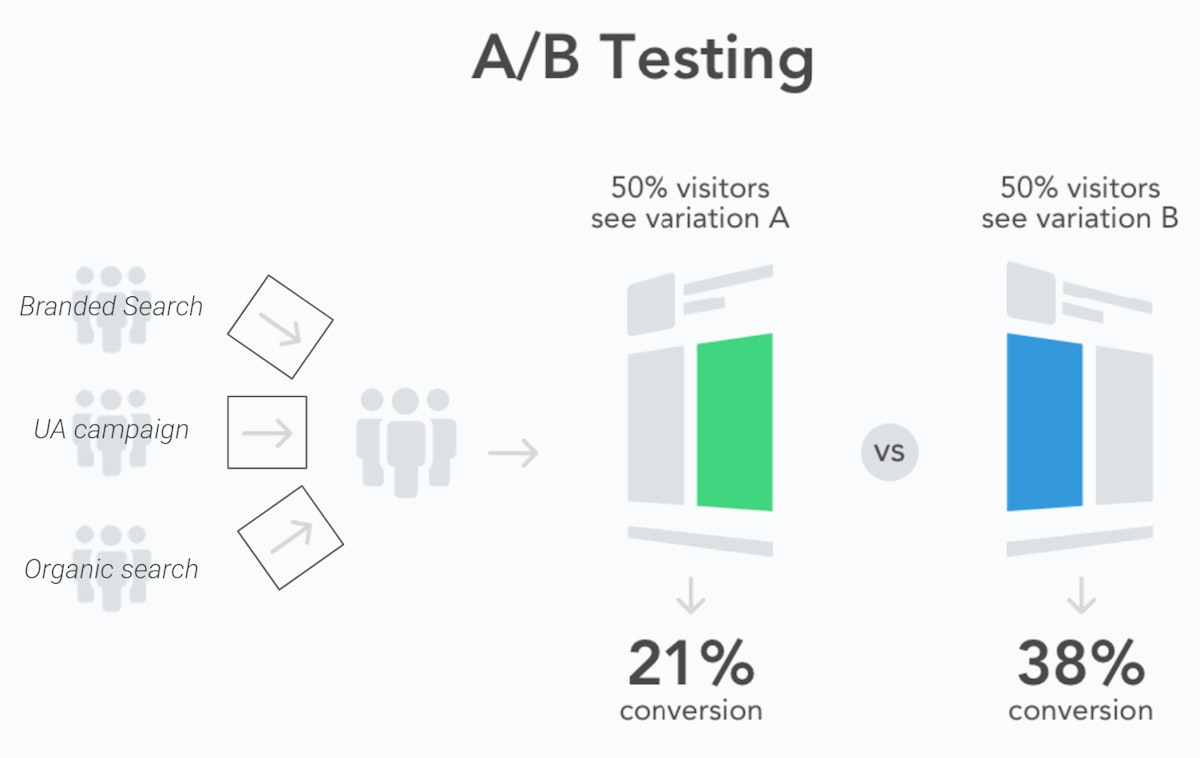

A/Bテストはモバイルマーケティングにおける標準的な手法となっており、ASOも例外ではありません。その原則はシンプルです:

- オーディエンスを様々なサンプルに分割する

- 異なるバリアント(例えば、異なるスクリーンショットのセット)を表示する

- 個人の好みではなくデータに基づいて、各バリアントのパフォーマンスを測定し、どちらを使用するかを決定する

問題は、テスト結果はテスト自体の信頼性に依存するということです。Google Playには、ネイティブ環境でテストを実行できるという大きな利点がありますが、多くのASO担当者は、勝利したバリアントを100%のユーザーに適用した後、実際には発生しなかったコンバージョン率の向上をツールが予測するのを見てきました。

Google PlayのA/Bテストにおける「統計的ノイズ」

Google Playの結果における偽陽性の主な原因の1つは、テストサンプルがどのように構築されるかです。Google Play Store Experimentsの結果におけるデータの内訳の欠如は、GoogleのA/Bテストツールが異なる種類のユーザーを区別できない可能性があることを意味します。これは、アプリのストアページを訪れるユーザーが多様な意図を持っているため、テストサンプルのコンバージョン率に大きな不均衡を生じさせる可能性があります:

- ブランドを検索するユーザーは、認知度が高いため、アプリを迅速にダウンロードする可能性が高いです。

- 広告キャンペーンや一般的な検索からのユーザーは、広告の約束がアプリから得られるものと一致することを確認しようとする場合があり、そのためストアリスティングの要素により敏感になります。

Google Play Store ExperimentsでA/Bテストを実施する際、ユーザーはトラフィックソースによってフィルタリングされません。

A/Bテストの異なるバリアントに割り当てる前にユーザーを区別しないことで、Google Play Store Experimentsでは、異なるテストサンプルがかなり異なる構成になり、その結果、異なるバリアントとは無関係のコンバージョン率の大きな違いが生じる可能性が高くなります。

もう一つの懸念は、ストアの動向における季節性の影響であり、テストサンプルのパフォーマンスが日々変動することです。これは制御できませんが、A/Bテストを実施する際にこれらのパラメータを考慮することができます:

- 週ごとのパターンの影響を軽減するために、テストを最低7日間実行してください。Googleはこの慣行を推奨していますが、彼らのプラットフォームはしばしば数日以内にA/Bテストの結果を提供します。しかし、多くの開発者は、テストを数日延長すると、結果が大幅に変わることがあり、テストの勝者が逆転することさえあると指摘しています。

- ユーザーがまだ季節イベントの準備をしていないため、そのクリエイティブを事前にA/Bテストしないでください。イベントの開始時にテストするか、新しいクリエイティブをすぐに適用して、事前/事後のコンバージョン分析を行ってください。

祝日シーズンのケーススタディでアプリの季節性トレンドについて詳しく学ぶ

統計的有意性と統計的検出力の違い

Google Play Store ExperimentsとA/Bテストを理解することは、その背後にある統計モデルのために困難です。A/Bテストは、バリアントAとバリアントBの結果間の有意な差を判断する必要があります。また、真の差を正しく検出する可能性(偽陰性を回避する)と、差がないのに差があると誤って結論付ける可能性(偽陽性を回避する)も示す必要があります。

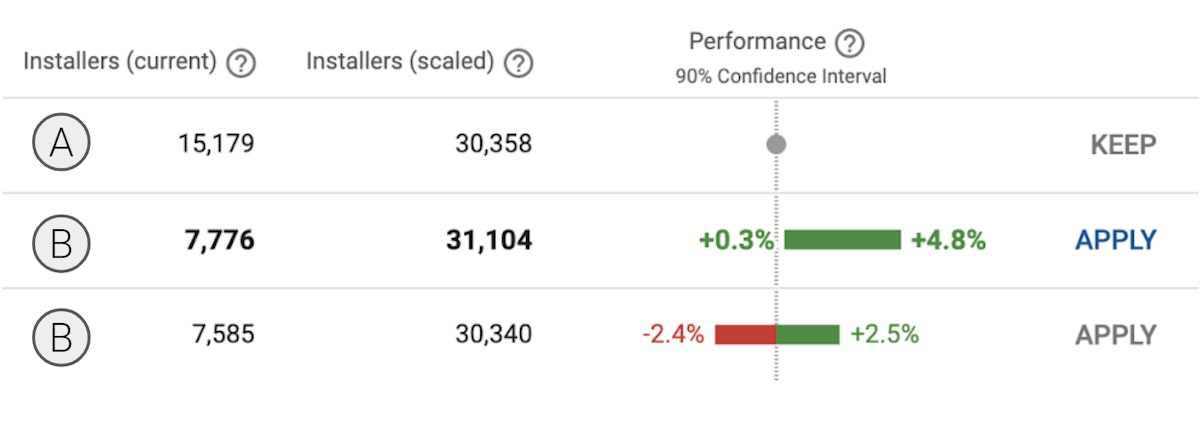

Google Play Store Experimentsはすべて、90%信頼区間と呼ばれる統計モデルに依存しており、これにはすでに2つの大きな欠点があります:

- 有意水準は、ほとんどのA/Bテストで使用される95%信頼区間の標準を下回っています。

- Play Store Experimentsは、異なるテストがどれほど信頼できるかについて明確なデータを提供しません。これにより、すべてのテストが予測された結果につながる可能性が同じであると信じてしまうかもしれませんが、実際には、一部のテストは他のテストよりも信頼性が高いのです。

実験の統計的検出力はサンプルサイズに依存します。サンプルサイズが大きいほど、偽陽性のリスクが低減し、コンバージョンにおけるわずかな改善を検出する可能性が高まります。

偽陽性結果を特定するためのA/B/Bテストの実行

Google Play Experimentsが偽陽性結果を頻繁に与える理由として考えられる原因を特定した上で、私たちのチームは、それらに遭遇するリスクをどのように制限できるかについて考えようとしました。同時に、テスト結果から、私たちの結果が偽陽性である可能性を事前に知る機会を増やすことも試みました。

私たちの結論は次のとおりです:

- 週ごとの季節性による誤解を招く可能性のある結果を制限するために、すべてのテストを最低7日間実行し続けることが重要です。すべてのテストの統計的検出力を高めるのに十分なサンプルサイズを確保することが重要です。

- ASO担当者は、マーケティングチームがUAキャンペーンを実施している間もテストを実行することをためらうべきではありません。しかし、各マーケティングチャネル間のトラフィック分割がテスト全体を通じて安定していることを確認する必要があります。

- テストで同じBバリアントを2つ作成すること(実質的にA/BテストではなくA/B/Bテストを設計すること)は、結果が真陽性か偽陽性かを評価するのに役立ちます。両方のBサンプルが同様の結果を提供する場合、これらは真陽性である可能性が高いです。一方、異なる結果である場合、どちらか一方が偽陽性である可能性が高いです。

- この構造の結果として、サンプルはそれぞれ33.34%、33.33%、33.33%のトラフィックを持つべきであり、他の(C)バリアントをテストに追加すべきではありません。

1番目と2番目のBサンプル間で結果が大きく異なる場合、A/B/Bテストは、2つの結果のうち少なくとも1つが偽陽性である疑わしい結果を特定できます。

この新しいプロトコルの主な利点は、1週間以内にテストの信頼性を評価することです。対照的に、一般的な方法では、最初の週にA/Bテストを実施し、2週目にB/Aテストを実施して初期結果を確認します。どちらのアプローチも偽陽性を防ぐのに効果的です。しかし、A/B/Bテスト構造は、アクションに必要な時間を短縮し、「確認」サンプルが同時にテストされることを保証し、潜在的な季節性バイアスを回避します。

A/B/Bテスト手法の影響の評価

統計について学んだ上で、A/B/Bテストに関する次の目標は、ASO担当者にとってそれがもたらしうる真の影響を評価することです。そのため、私たちは意欲のあるすべての読者に、この手法をアプリで試してAppTweakと結果を共有するよう呼びかけています。そうすれば、後の記事でA/B/Bテストの真の影響、特に偽陽性結果をどれくらいの頻度で検出できたか、または検出するには不十分だったかについて、皆様と共有できることを願っています。

各テストについて、皆様からお伺いしたい情報は以下のとおりです:

- アプリ名(任意)

- アプリカテゴリ

- テストのストアリスティング(グローバル / en-usデフォルト / en-uk / es-spain / …)

- 開始日と終了日

- どのようなバリアントタイプをテストしましたか?

- 適用されたトラフィック分割

- バリアントごとのインストール数

- 信頼区間の下限

- 信頼区間の上限

- 適用されたバリアントについて、テスト後の週とテスト前の週の間のコンバージョン率の向上

テスト結果を共有するためのテンプレートはこちらでご確認いただけます。このデータはAppTweakによって機密保持され、A/B/Bテスト手法に関する統計を集計するためにのみ使用されます。

テスト結果を共有したい場合、またはA/B/B手法に関して質問がある場合は、当社のウェブサイト、Eメール、ソーシャルメディア、またはASO Stack Slackチャンネルを通じて、私たちのチームにご連絡ください。

Oriane Ineza

Oriane Ineza

Micah Motta

Micah Motta